PCB là một trong những khái niệm cơ bản nhất mà một thợ điện mới bắt đầu cần phải nắm vững. Có thể, bạn đã nghe thấy pcb ở khắp mọi nơi, và nó quen thuộc đến mức bạn quên mất khái niệm chính của từ này. Nếu bạn là người mới bắt đầu về điện tử hoặc đang học các khái niệm và thuật ngữ liên quan đến pcb. Vui lòng tham khảo cách viết sau

Nguồn: Kiến thức cơ bản về PCB – Học sparkfun (tiếng Anh)

pcb là gì?

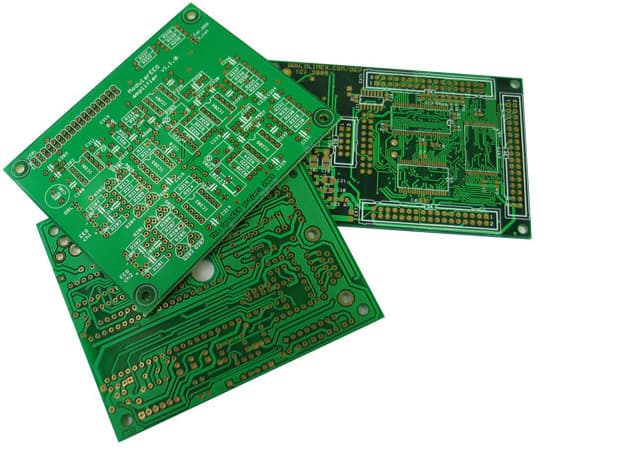

pcb là viết tắt của (Bảng mạch in) hay còn gọi là Bảng mạch in. Pcb sẽ có nhiều lớp và không thể tự dẫn điện mà phải dựa vào các đường dẫn và các điểm đệm trên bề mặt. Các đường dẫn này sẽ dùng để kết nối và truyền tín hiệu điện giữa các điểm nằm ở các vị trí khác nhau trên pcb

Do đó, dựa vào đường dẫn pcb sẽ cho phép truyền tín hiệu và nguồn điện giữa các thiết bị vật lý (như ic, điện trở, cuộn cảm …) được gắn trên bề mặt của nó. Để truyền tín hiệu trên pcb, bạn phải thực hiện quá trình hàn để tạo kết nối điện giữa pcb và các linh kiện điện tử. Ngoài việc thực hiện các nhiệm vụ điện, chất hàn hoạt động như một chất kết dính để giữ cho các linh kiện không rơi ra khỏi mạch

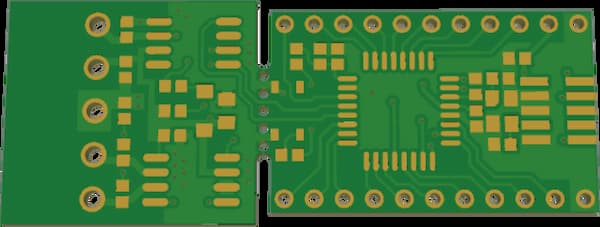

Tóm lại, pcb nguyên bản sẽ có hình như sau, mạch không cố định, người dùng có thể tự thiết kế theo ý mình. PCb là một bo mạch đơn giản không có bất kỳ thành phần nào trong số này

Lịch sử của pcb

Bảng mạch in pcb là một tên thông dụng ngày nay, trước khi nó được biết đến với các tên khác như “bảng mạch in” và “thẻ mạch in”.

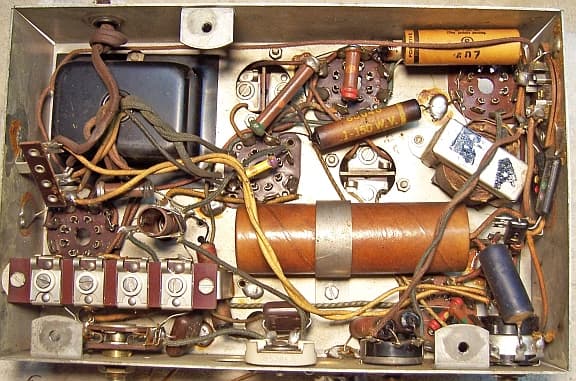

Trước khi pcb ra đời, các mạch cũ được xây dựng bằng hệ thống dây điểm-điểm, tốn nhiều thời gian, công sức, hỗn loạn và đặc biệt khó xử lý khi có sự cố (tham khảo hình bên dưới). Loại mạch kiểu cũ này có thể bị hỏng khi lớp cách điện của dây bị cũ hoặc bị nứt. Thường xuyên xảy ra lỗi dây và đoản mạch

Một tiến bộ lớn khác sau giai đoạn này là sự phát triển của các cuộn dây, trong đó một dây khổ nhỏ được quấn quanh một trụ tại mỗi điểm kết nối để tạo ra một kết nối kín khí và bền. Cao hơn và dễ thay thế hơn

Khi thiết bị điện tử chuyển từ sử dụng ống chân không và rơ le sang silicon và mạch tích hợp, kích thước và giá thành của các linh kiện điện tử bắt đầu giảm. Lúc này, các sản phẩm điện tử trở nên phổ biến hơn, đánh dấu thời kỳ bắt đầu phát triển mạnh mẽ của các sản phẩm điện tử cho đến ngày nay

Bạn có thể thấy mạch pcb ở hầu hết mọi nơi, chẳng hạn như điện thoại, TV, máy tính, máy giặt, tủ lạnh … hầu hết tất cả các thiết bị điện tử trong nhà bạn

pcba là gì?

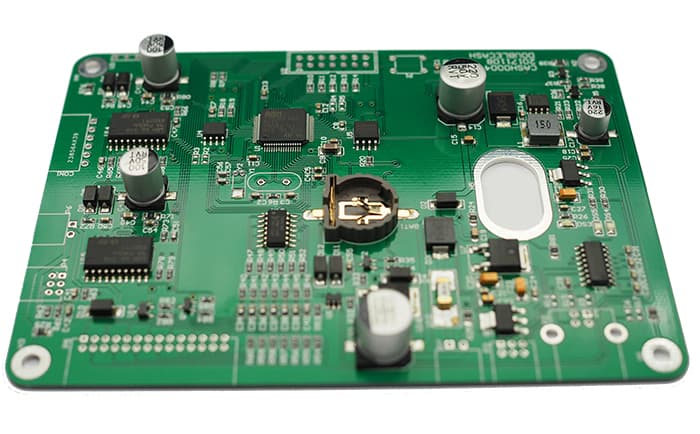

Khái niệm cơ bản tiếp theo mà đôi khi bạn quên là pcba. pcba là viết tắt của cụm từ Printed Circuit Board Assembly, một khái niệm dùng để chỉ một mạch pcb đã hoàn thiện. Nói cách khác, khi một mạch được gắn hoàn toàn với một thành phần điện tử trên bề mặt, chẳng hạn như điện trở, ic, tụ điện hoặc bất kỳ thành phần nào khác và có thể thực hiện chức năng của nó

PCBA thường được hàn và có thể được thực hiện bằng tay hoặc bằng cách lắp bề mặt (smt) và hàn lại để tạo kết nối hoàn chỉnh giữa linh kiện và mạch in

Vì vậy, nếu ai đó hỏi bạn sự khác biệt giữa pcb và pcba là gì? Sau đó, bạn có thể dễ dàng trả lời rằng pcb là một mạch in không có linh kiện và pcba là một mạch lắp ráp hoàn chỉnh hoạt động

Nếu bạn là người mới tham gia lĩnh vực này, có lẽ bạn nên xem bài viết rất chi tiết này về cách hàn các linh kiện và bàn là hàn chì lidinco tốt nhất

Các thành phần tạo nên pcb?

Như đã đề cập trong khái niệm, pcb là một bảng mạch in xen kẽ với nhiều lớp vật liệu khác nhau. Mỗi lớp sẽ đóng một vai trò riêng biệt, được liên kết bằng nhiệt hoặc chất kết dính để tạo thành một khối riêng biệt

Chất nền fr4 (epoxit hoặc phenolic)

Đây là lớp vật liệu cơ bản nhất có thể được coi là chất nền của pcb, thường là sợi thủy tinh. Trong lịch sử, vật liệu phổ biến nhất cho chất nền này là sợi thủy tinh “fr4”. fr4 sẽ giúp pcb có độ cứng và độ dày tốt, không dễ gãy, nứt. Ngoài ra, có những loại pcb linh hoạt được thiết kế dựa trên nền nhựa nhiệt dẻo nhiệt độ cao (có thể là kapton hoặc tương đương)

PCb sẽ có độ dày khác nhau tùy theo số lớp của mạch in, một số độ dày phổ biến là 1,6mm (0,063 “) hoặc độ dày 0,8mm cho mạch adruino

Bảng mạch in và bảng mạch rẻ tiền thường được làm từ các vật liệu khác như epoxit hoặc nhựa phenolic. Chúng sẽ không bền như fr4, nhưng nếu được làm từ những vật liệu này thì giá thành sẽ thấp hơn đáng kể. Những pcb giá rẻ này có thể nhận biết được bằng cách hàn trực tiếp và thường có mùi khó chịu.

Những chất nền giá rẻ này thường được tìm thấy trong các thiết bị điện tử tiêu dùng giá rẻ của Trung Quốc, đó là lý do tại sao một số thiết bị điện tử gia dụng từ Trung Quốc lại rẻ đến vậy. Nhiệt độ phân hủy do nhiệt của chất nền phenolic thấp và việc tiếp xúc lâu dài của mỏ hàn với bảng mạch in có thể gây tách lớp, khói và đen

Đồng

Lớp tiếp theo của bảng mạch in là một lá đồng mỏng, được dát mỏng bằng nhiệt và chất kết dính. Trên các tấm pcb 2 mặt truyền thống, đồng được mạ ở cả 2 mặt của đế. Trong các thiết bị điện tử giá rẻ hơn, pcb có thể chỉ có đồng ở một mặt. Khi ai đó đề cập đến bảng hai mặt hoặc 2 lớp, họ thường đề cập đến số lớp đồng sản xuất tạo nên pcb (2).

Tính toán này có nghĩa là một mạch pcb có thể có ít nhất 1 lớp đồng (mạch 1 lớp) hoặc 16 lớp đồng (mạch 16 lớp) trở lên

strong>

Độ dày của đồng có thể khác nhau và được quy định theo trọng lượng, thường ở một số quốc gia, lượng đồng được phủ lên bề mặt được đo bằng ounce trên foot vuông. Hầu hết các PCB sẽ được bao phủ bằng đồng 1 oz trên mỗi foot vuông, nhưng một số PCB xử lý công suất rất cao có thể sử dụng đồng 2 hoặc 3 oz.

Theo công thức này, mỗi ounce trên mỗi foot vuông pcb tương ứng với độ dày khoảng 35 micrômet

Mặt nạ lớp

Lớp trên cùng của lá đồng được gọi là mặt nạ hàn. Đây là lớp tạo ra màu đặc trưng cho mạch in, thường là màu xanh lá cây (và đôi khi là các màu khác như xanh, đỏ, tím, trắng tùy hãng).

Nó được bao phủ bởi một lớp đồng được sử dụng để cách ly các dây dẫn điện khỏi sự tiếp xúc ngẫu nhiên hoặc bám dính với kim loại bên ngoài, vật hàn hoặc các điện thế dẫn điện khác. Ngoài ra, lớp mặt nạ này còn có thể giúp người dùng hàn đúng vị trí và tránh bị nhảy mối hàn.

Mặt nạ hàn sẽ che gần hết bề mặt nhưng sẽ để lộ các vòng bạc và miếng đệm smd để người dùng có thể hàn các bộ phận vào những vị trí này

Lớp màn hình lụa

Lớp lụa hay còn gọi là lớp mực là lớp cuối cùng được phủ lên pcb sau khi hoàn thành các bước trên. Lớp này thường thêm chữ, số và ký hiệu vào pcb để người dùng lắp ráp linh kiện dễ dàng hơn, tức là nó sẽ kiểm tra khắp nơi để xem loại linh kiện nào cần dán và giá trị là bao nhiêu. Tùy thuộc vào tình trạng sẵn có

In lụa phổ biến nhất là màu trắng, nhưng bất kỳ màu mực nào cũng được, tùy thuộc vào cách phối màu của mặt nạ hàn sao cho nổi bật và dễ nhìn. Lớp mực có thể có màu đen, xám, đỏ, hoặc thậm chí vàng. Tuy nhiên, bạn sẽ hiếm khi thấy nhiều hơn một màu trên bàn vì nó khiến người dùng bối rối

Một số thuật ngữ thông dụng trong mạch pcb

Sau khi bạn hiểu các khái niệm cơ bản nhất về pcb, có lẽ bạn cũng nên tìm hiểu thêm về các thuật ngữ thường được sử dụng xung quanh pcb, mọi người nói gì?

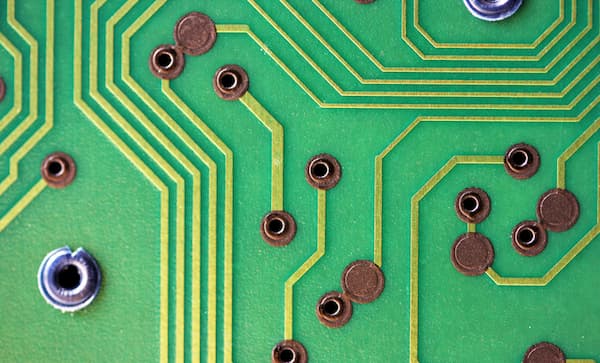

– Annular Ring – là một vòng đồng được mạ xung quanh các lỗ của pcb.

– drc (Kiểm tra quy tắc thiết kế) – Kiểm tra quy tắc thiết kế. Đây là quá trình kiểm tra thông qua phần mềm sau khi bo mạch đã được thiết kế trên hồ sơ để đảm bảo thiết kế không có lỗi như chạm, hở mạch, sai dây, vết quá mỏng, hoặc khẩu quá nhỏ.

– Không có lỗ nước (Khoan) – Một lỗ được khoan trên bề mặt của pcb được sử dụng làm vị trí để thắt chặt hoặc định vị các đầu nối. Một lỗi phổ biến trong quá trình khoan là sai bit do mòn bit, một vấn đề sản xuất phổ biến.

– ngón tay – là một miếng kim loại chạm dọc theo cạnh của mạch in để tạo kết nối giữa hai bảng mạch, đây được coi là một loại miếng đệm đặc biệt. Một ví dụ phổ biến là khe cắm thẻ nhớ ram của máy tính hoặc máy chơi game cũ.

-panel – một bảng mạch lớn hơn bao gồm nhiều pcb nhỏ bên trong, thông thường những bảng mạch lớn này sẽ được tạo ra bởi một nhà sản xuất bảng, sau đó bằng cách cắn chuột hoặc v-scope chúng ta có thể tách phần phụ ra. -chuyển đổi và tiếp tục sử dụng nó. Các tấm thông dụng trong quy trình sản xuất hàng loạt pcb

– Cắn chuột – Một giải pháp thay thế cho phạm vi v để tách mạch in khỏi bảng lớn. Đây là bộ mũi khoan đặt gần nhau tạo điểm yếu giúp bạn có thể dùng lực nhẹ tách pcb ra khỏi panel mà không lo hỏng mạch (như trò chơi ghép hình). )

– Miếng đệm – là các điểm tiếp xúc bằng kim loại trên bề mặt của pcb, đây là nơi các thành phần sẽ được hàn.

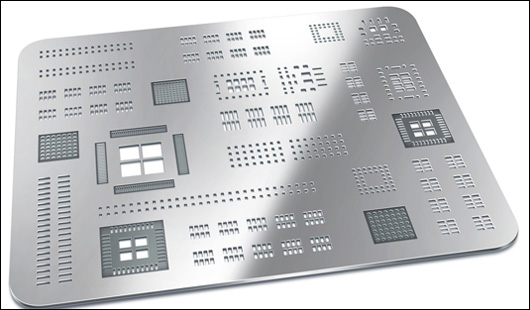

– Bút chì dán – Có thể là một chiếc bút chì kim loại mỏng (hoặc đôi khi bằng nhựa) được thiết kế để đi theo đường dẫn của pcb, công việc của nó là giữ cho chất hàn kem ở đúng vị trí như thiết kế. Khi đặt giấy nến lên bề mặt pcb, bạn chỉ cần bôi keo hàn lên và keo hàn sẽ vào đúng vị trí bạn muốn hàn

– Mặt phẳng – Một khối đồng liên tục trên bảng mạch, được xác định bằng đường viền chứ không phải đường dẫn.

– Mạ Xuyên qua lỗ – Một lỗ trên bảng mạch được mạ từ mặt này sang mặt kia. Lỗ mạ này có thể được sử dụng làm điểm kết nối cho các thành phần xuyên lỗ để truyền tín hiệu

– pogo pin – là một công cụ được nạp vào lò xo để kiểm tra các điểm đệm trên bề mặt của pcb để xem nó có đúng như thiết kế và được cấp nguồn hay không. Có thể được sử dụng để kiểm tra cố định thủ công hoặc kiểm tra máy tự động

Xem chi tiết và giá sản phẩm

—screen —các bản tin, số, biểu tượng và hình ảnh trên bảng mạch. Thường chỉ có một màu và độ phân giải thường thấp.

– Ổ cắm – Bất kỳ lỗ nào trên bảng không tròn được gọi là ổ cắm. Các ổ cắm có thể được mạ hoặc không được mạ, và các ổ cắm đôi khi có thể làm tăng thêm chi phí cho việc chế tạo pcb vì chúng đòi hỏi thêm thời gian cắt.

– Keo hàn (Dán hàn) – Các tinh thể thiếc hoặc chất hàn tạo thành dung môi lỏng màu trắng đục bám vào các miếng gắn trên bề mặt. Đặt các thành phần. Sau khi quét và hàn trên pcb, nó sẽ được nấu chảy thông qua một lò hàn và chất hàn trong hồ sẽ nóng chảy để tạo thành các kết nối điện và cơ học giữa các miếng đệm và các thành phần.

– Pick and Place (Chọn và Đặt) – là một loại máy thông dụng trong việc tự động hóa quy trình sản xuất bo mạch chủ. Nhanh chóng đặt các linh kiện đã dán vào đúng vị trí được lập trình trên mạch pcb với độ chính xác của bộ chọn linh kiện

Xem chi tiết và giá sản phẩm

– Bể hàn nhúng (Nồi hàn) – Thiết bị này được sử dụng để hàn nhanh thủ công các bảng mạch với các thành phần có lỗ. Thiết bị sẽ có một bể nhúng, nơi chất hàn sẽ được đặt và nấu chảy, sau đó chỉ cần nhúng pcb vào chì và các mối nối hàn sẽ ở lại trên tất cả các miếng đệm

– Mặt nạ hàn – Một lớp vật liệu bảo vệ bao phủ kim loại để tránh đoản mạch, ăn mòn, v.v. Thường có màu xanh lục, có thể có một số màu khác

– cầu hàn (cầu nối hàn) – là các khớp hàn nhỏ trên pcb được sử dụng để tách hoặc kết nối các miếng đệm / miếng đệm với nhau. Tuy nhiên, bạn cần cẩn thận khi sử dụng thủ thuật này vì có thể dẫn đến đoản mạch nếu không đúng kỹ thuật

Xem chi tiết và giá sản phẩm

– Surface Mount (Surface Mount) – Công nghệ Surface Mount hay còn gọi là Surface Mount (smt), thường được sử dụng trong các thành phần smd. Hiện nay công nghệ rất phổ biến

– trace – là đường dẫn từ điểm này đến điểm khác trên mạch pcb

– v-score (v-score) – là đường cắt qua bàn, có thể dễ dàng cắt bàn thành một đường thẳng (bàn có bảng điều khiển))

– qua – Một lỗ trên bảng được sử dụng để truyền tín hiệu từ lớp này sang lớp khác. Vias có thể được phủ bằng thuốc hàn để bảo vệ chúng khỏi bị hàn. Các đầu nối và các thành phần gắn với vias thường không được hàn để kết nối dễ dàng hơn

– Hàn sóng (Sóng hàn) – Một phương pháp hàn được sử dụng trên bo mạch có các thành phần xuyên lỗ. Mạch được hàn bằng phương pháp hàn sóng sẽ được đưa vào nồi hàn nóng chảy, dưới tác dụng của bơm sẽ tạo thành sóng hàn dội ra pcb. Lúc này, chất hàn sẽ dính vào các tấm đệm và dây dẫn của các thành phần tiếp xúc. Các nhà sản xuất bo mạch chủ thường sử dụng phương pháp này

Vì vậy, lidinco giới thiệu những lưu ý sơ bộ đối với bảng mạch in cho các bạn, mong rằng các bạn sẽ có được những kiến thức bổ ích

Có thể bạn quan tâm

-Danh mục vạn năng giá rẻ-Danh mục máy hiện sóng giá rẻ